会話をしましょう!

言葉というコミュニケーションツールは多様性と複雑性の意味においてユニークです。私たちの自然言語は複雑なインタラクション、プランニング、会話をすること、そして最も重要なことですが、時間と空間から切り取って抽象に使うことを可能にします。何千年にも亘り話すことと聞くことは人間に利便性をもたらしました。コンピューターの発明により情報転送や処理が確実に機能する為の新しい言語の開発の必要性が生まれました。以来、様々なプログラミング言語が人間の文化遺産を構成するようになってきました。

しかしながら、自分の言語でコンピューターシステムと直接インタラクティブにかかわる人は殆どいません。私たちはつまり、コンピューターの能力を使って人間の言語をコンピューターの言語に翻訳することを通じて業務を行います。はじめは、パンチ穴のあいたカードやテープを使ってコンピューターにコマンドや情報を伝達しました。1970年頃から、文字による入出力によりコンピューターシステムとの言語によるインタラクションを行いました。タッチ画面が 2000年頃から重要な役割を果たすようになりました。 しかしこれらすべてのインターフェイスは人とシステムのあいだに目に見えないバリアをつくってしまいました。2010 年頃になってはじめて私たちはコンピューターやスマートフォンやスマートスピーカーに自分の言語で話すようになりました。しかし、私たちは以前それらと会話したり、うわさ話やチャットをすることはありません。いったい何故でしょうか。

ユーザーアクセプタンス – チャレンジ

「音声アシスト」に関して自然言語によるコミュニケーションに私たちはまだほど遠いという事実が人が話す自然言語の膨大な複雑性と曖昧さと関係しているというのは確かです。コンピューターは厳格に論理的に組み立てられたシンボリックな言語で動作する為、これらのことは人が発話するコマンドを音声アシストが正しく理解して反応し、人とマシンのコミュニケーションのインターフェイスとして受け入れられるレベルまで利用者の期待に応えるのが難しくする要素です。フラストレーションがすぐに限界に達し、結果が期待外れとなってしまうことは希ではありません。背後にある複雑性に対する理解がなく、市場で販売されているのだから音声アシストは完璧に機能するものと純粋に信じるユーザーは特に期待を裏切られます。しかし、実際に何が問題なのでしょうか。それを理解するには音声アシストが機能する原理にまで遡らなければなりません。

ASR自動音声認識 (ASR) と 自然言語処理 (NLP)

自動音声認識 (ASR) において音声モデル は通常、音信号と複数の単語や音素から成る基本ブロックとのあいだの関係をモデル化し、コンピューターが読み込めるように音信号をビットデータに変換します。コンピューター言語を用いて、音声と発音モデルがこのデータを正しい順番とコンテクストで関連づけて単語や文章にします。

最初の問題は、環境ノイズ、話者のマイクに対する位置、複数話者の混線といった要素が、自動音声認識システムが受けとる信号に影響するということです。音声認識を完全なものとする為には、障害は取り除かれ、音声のみが受けとられなければなりません。しかし、これは現実には不可能です。その為自動音声認識システムは 妨害に対してロバストである必要があります。

ひとたび言語が認識され単語と文章に組み立てられたら、今度は言語処理の番です。キーワードは自然言語処理 (NLP) です。 自然言語処理 (NLP) はコンピューターサイエンス、特に AI の一種であり、コンピューターに人間と同様にテキストや口語の意味を理解する能力を与えるものです。

しかしながら、前述の通り、人間の言語には曖昧さが多く含まれる為、テキストや音声データの意図した意味をコンピューターに伝えるのは非常に難しいことです。皮肉、慣用句、比喩、同音異義語は人の耳が正しく聞く為のハードルのごく一部に過ぎません。自然言語処理 (NLP) における高度 AI メソッドはここ数年で意味やシンタックスの複雑性を処理することにおいて大きな進歩を遂げました。 ディープラーニングメソッドや 重畳型ニューラルネットワーク (CNN) やリカレントニューラルネットワーク (RNN) ベースの学習技術により実にスマート化してきています。しかしながら、それらの中でもレベル較差があるのは否めません。

選択の難しさ

自動音声認識システムのメーカーにとって、そしてそれらが搭載される製品の製造メーカーにとって、システムが完璧に動作することは絶対マストです。しかし、どのデバイスに搭載されたどの音声認識システムがどの条件でベストの動作をするかは詳細の分析と実環境でのテストを行わなければ簡単に論じることはできません。マイクでさえ、例としてクローズアップやデスクトップマイクは千差万別でありスペクトルエネルギーのレベルや周波数特性も様々です。であれば、自動音声認識システムを搭載した製品のメーカーはどうしたら自動音声認識性能を確実に最適化できるでしょうか。

環境ノイズ、複数話者の混線、マイクとスピーカー位置関係等たくさんのバリエーションでテストを行うのがベストです。 実験室でも実際の環境条件をできうる限り網羅することが自動音声認識システムシステムと搭載したデバイスの開発と改善に不可欠です。 その一方で、バリエーションを多くするほどテストにより時間がかかり環境条件を正確に再現することがより難しくなります。

再現可能な方法でバリエーションテスト

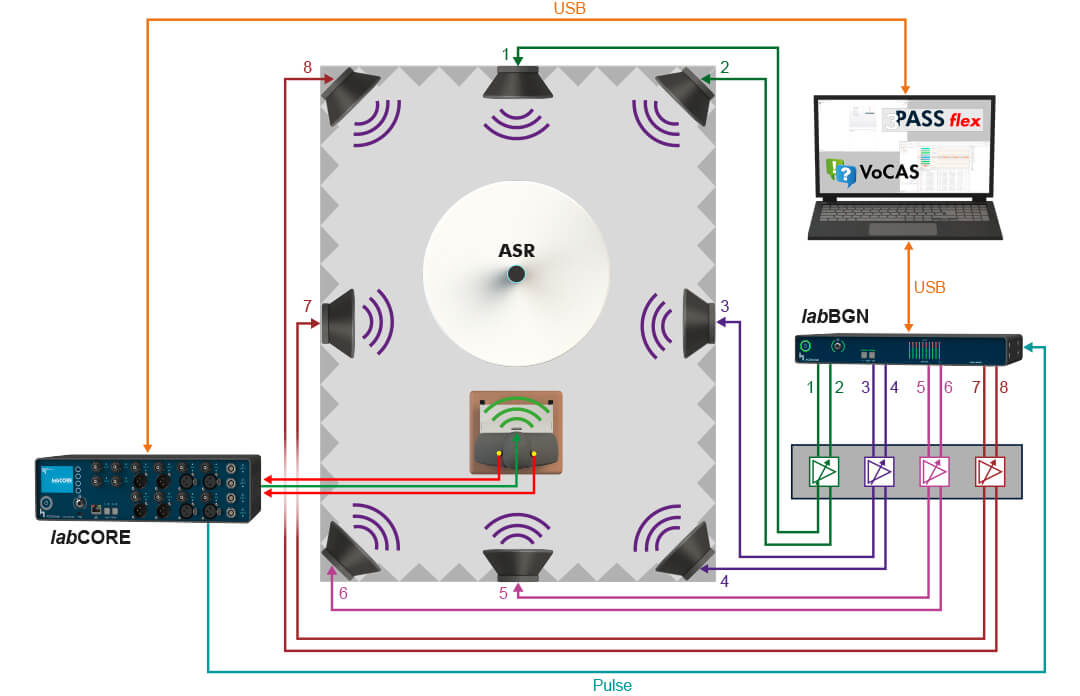

HEAD acoustics は VoCAS (Voice Control Analysis System) ソフトウエアをまさにこの目的の為に開発しました。 複雑なシナリオでも、音声認識機能搭載のデバイスのプレ信号処理性能をリアルにかつ客観的に評価します。このプレ信号処理の目的は、音声認識機能がクラウド上、デバイス上、ローカルサーバー上のいずれにある場合でも、その音声認識機能に渡る前の信号を障害となるアーティファクトから「クリーン」にすることです。

VoCAS を用いることにより自動音声認識システムやそれが搭載されたデバイスをテストする為のコンセプトづくり、構築、 自動化が可能です。 VoCAS はバックグラウンドノイズ、残響、様々な言語や訛り、混線する話者等すべての要素を考慮しニーズに合わせてテストや分析にこれらの要素を簡単に統合することが可能です。

複数のアーティフィシャルヘッドを同期させることにより 様々な方向から異なる音量で混線する妨害話者を考慮したシミュレーションが可能です。必要に応じて HEAD acoustics の ターンテーブル HRT I を用いることにより音声認識インターフェイス搭載端末を回転させマイクロホンから遠ざかる等のユーザーの動きをシミュレーションすることも可能です。

もちろん VoCAS はバックグラウンドノイズをシミュレーションするソフトウエアの制御も行います。3PASS flex、 3PASS lab、 HAE-BGN、 HAE-car 等のシステムは残響シミュレーター 3PASS reverb とともに日常のリアルな音響条件をいつでも再現することができます。動くクルマでの会話をしたり、グラスを合わせる音など騒々しいカフェテリアで MP3 プレーヤーを音声コマンドで操作したり、プラットフォームに電車が到着する場面でのナビへの目的地入力等を再現することができます。

VoCAS は音声認識システムを搭載した端末の性能に大きく影響するすべての要素を設定可能ですので、単純なケースも複雑なケースにも最適なかたちで対応可能です。テストでは音データ、即ちすべてのテスト信号を正確に再現することが重要であり、様々な音声認識システムのベンチマーキングに不可欠です。同時に、VoCAS はテスト対象システムについて比較可能なかたちで深い分析を行うことができ、最適化の為にはどの条件下のどの調整を行うべきか明確に提示します。

シンプルなほどよく – 実にいい!ほど好ましい

ユーザーフレンドリーなインターフェイスはケーキのトッピングとは異なり、特に高度に専門的な分析ソフトウエアにはマストです。機能の使い方がわからない為にソフトウエアを使いこなせないことほど腹立たしいことはありません。 VoCAS ならば音声認識システム向けの自動テスト信号を直感的に作成でき、搭載機能のレコーダーで音声コマンドを録音し、または既存のオーディオデータをインポートし、ファイルをカットやフィルター処理し、必要な音声レベルに校正することが可能です。

また VoCAS は膨大な数の音声コマンドをタグを使って素早く簡単にファイル管理可能です。Python スクリプト により音声認識システムの為のつと信号をカスタマイズしたり自動化することが可能です。VoCAS はテスト結果の評価も簡単です。VoCAS はクエリーが充実しており、また様々なインターフェイス要素のテスト実績も考慮に入れながら、音声認識機能についての疑問に正確に答えてくれます。

VoCAS には無限の可能性がありそれらを簡単に直感的に発見することが可能です。